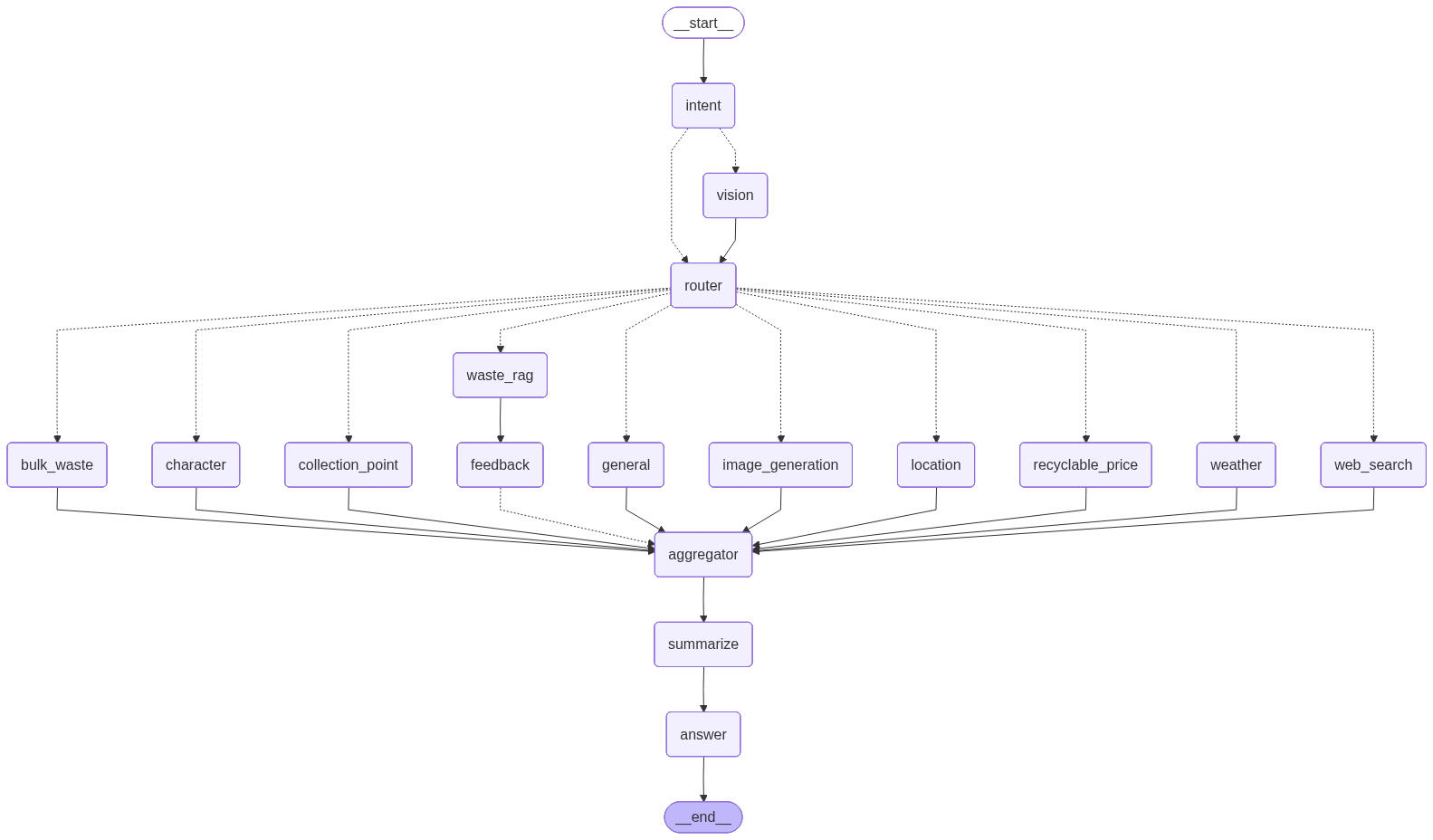

시스템 아키텍처 System Architecture

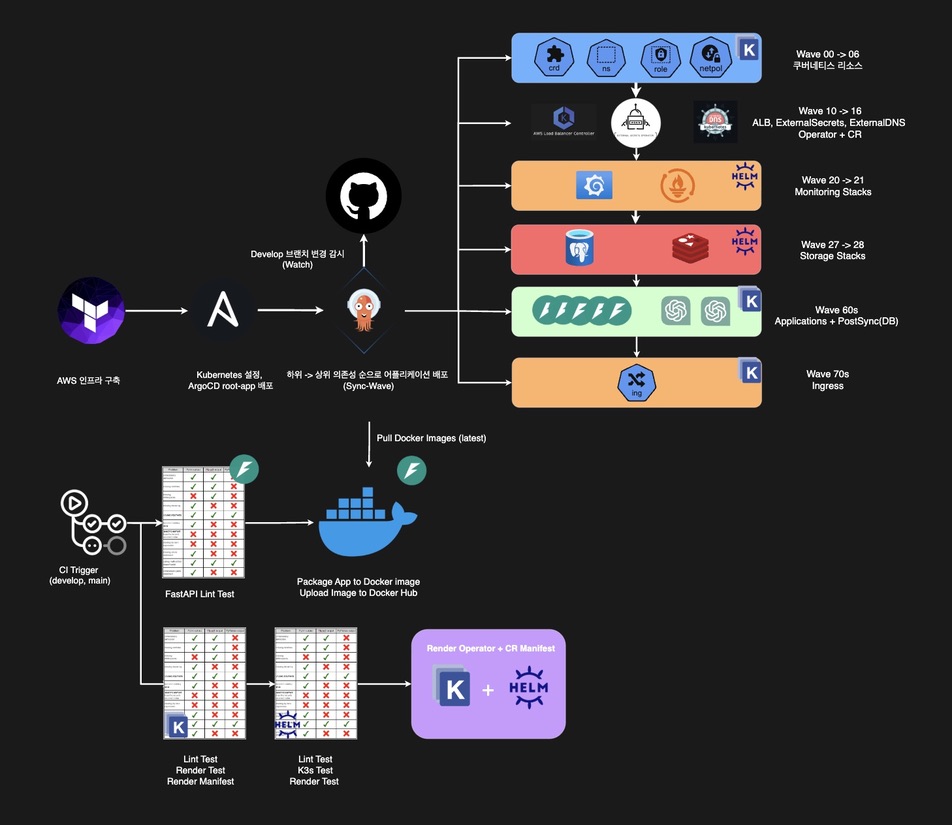

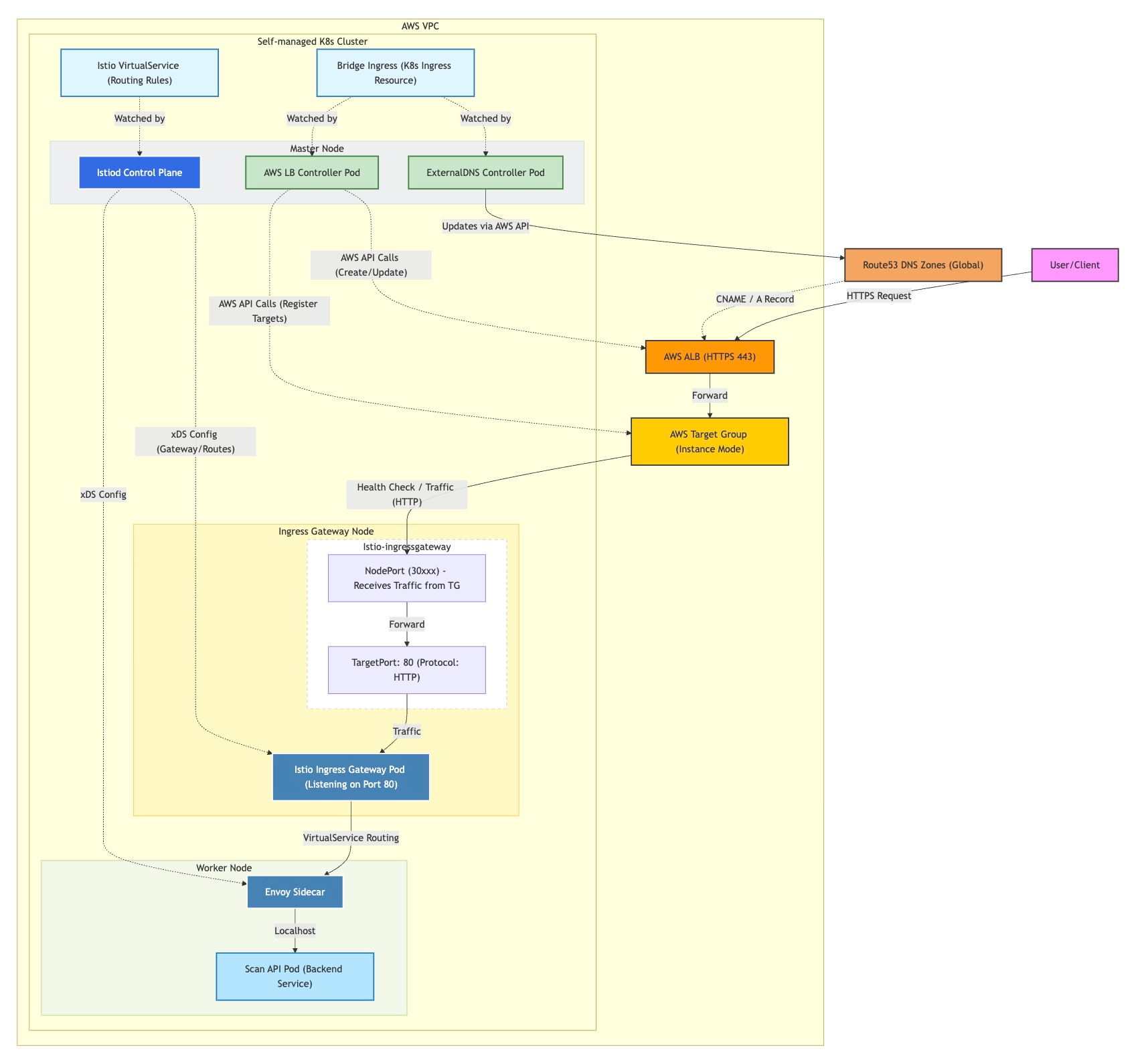

PWA 기반 프론트엔드와 연동되는 24-Node 분산 클러스터 아키텍처입니다. 24-Node distributed cluster architecture integrated with PWA-based frontend.

🏗️ 전체 시스템 아키텍처 🏗️ System Architecture Overview

📊 데이터 흐름 요약 📊 Data Flow Summary

| 흐름Flow | 경로Path | 프로토콜Protocol |

|---|---|---|

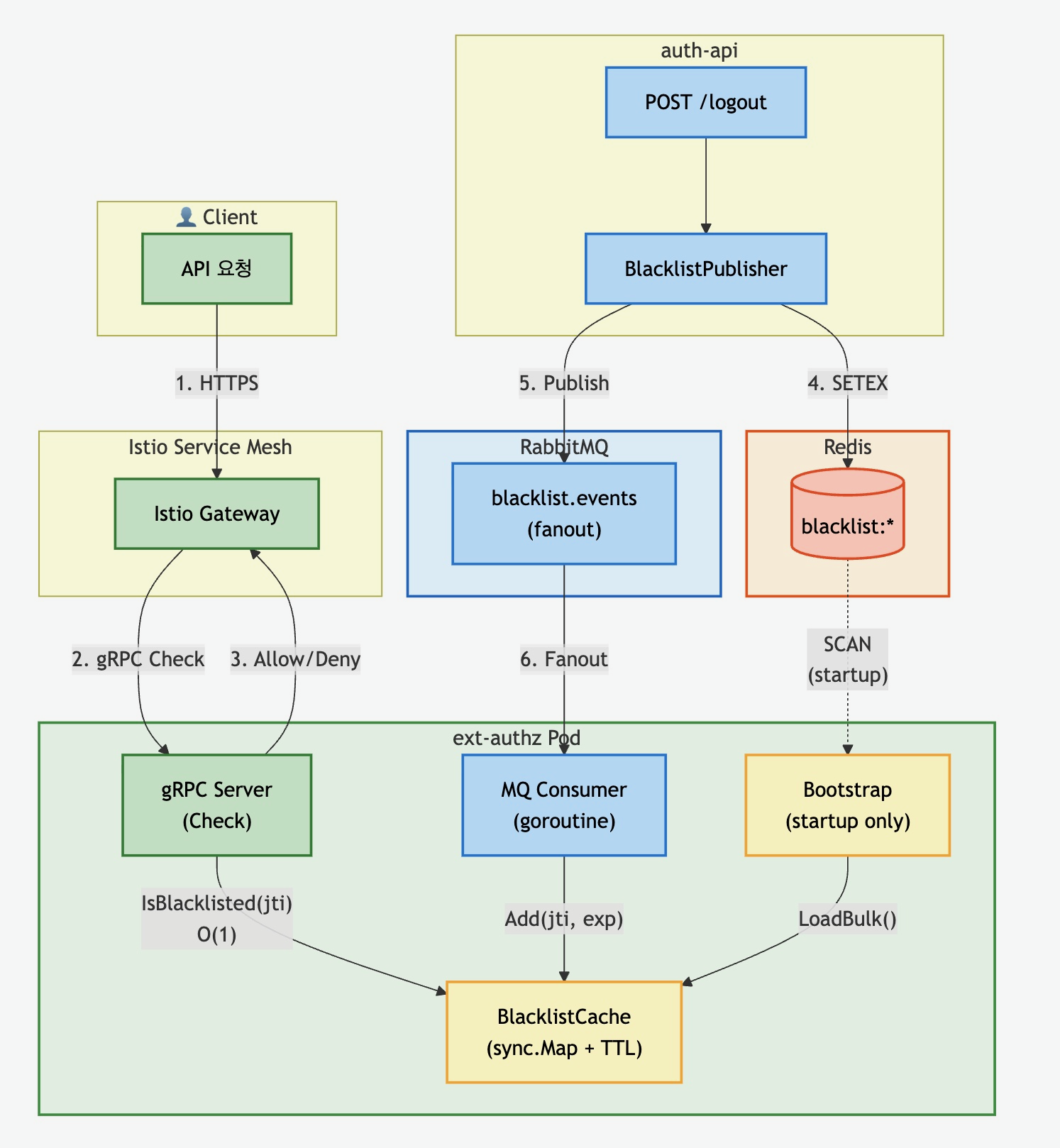

| 🌐 N-S Traffic | User → Route53 → ALB → Istio GW → ext-authz → APIs | HTTPS, gRPC |

| 🔄 E-W Sync | auth ↔ users, character → users (mTLS Envoy Sidecar) | gRPC |

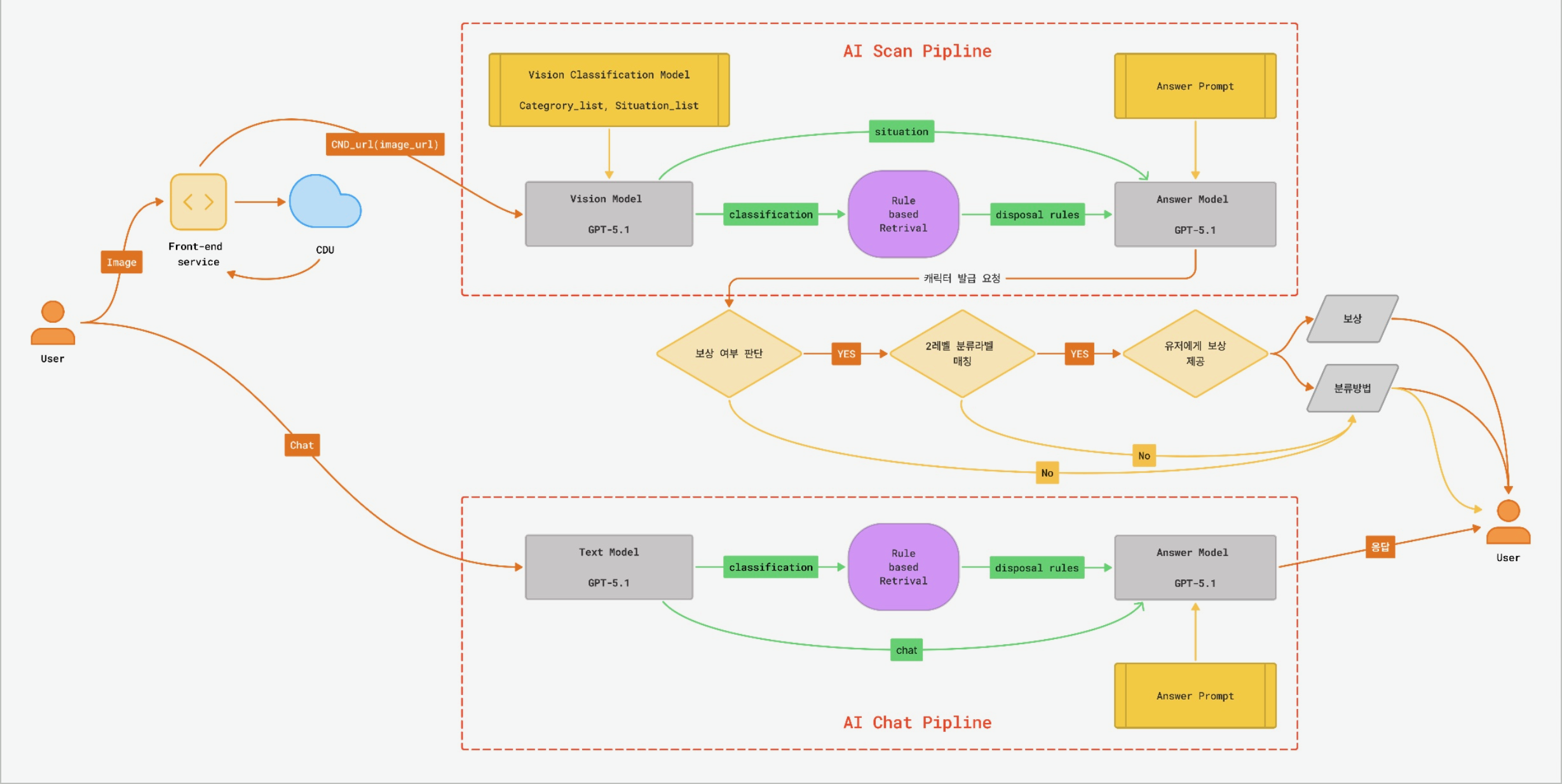

| 🤖 Scan AI | Scan API → RabbitMQ → scan-worker (Vision→Rule→Answer→Reward) → OpenAI API | AMQP, Celery Chain |

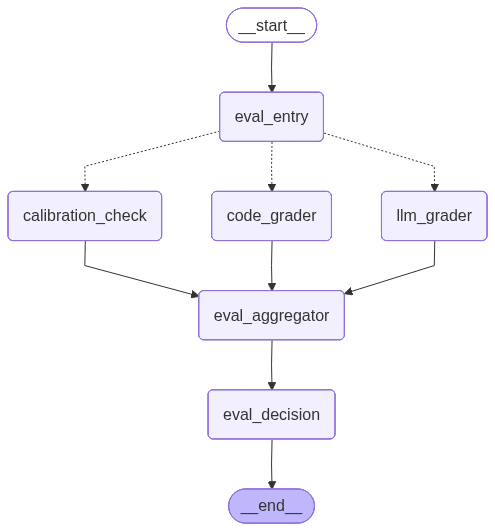

| 💬 Chat Agent | Chat API → chat-worker (Intent→TagRetriever→EvalAgent→Fallback) → YAML inject + OpenAI API |

Taskiq, LangGraph |

| 🎭 Character Batch | scan-worker → character-match → character-worker (batch) → users-worker (UPSERT) → PostgreSQL | AMQP, Batch Insert |

| 📡 SSE Event | Workers → Redis Streams → Event Router → Pub/Sub → SSE GW → Client | XADD, PUBLISH, SSE |

| 🔔 Auth Relay | Auth API → Redis Fallback Outbox → auth-relay → RabbitMQ Fanout → auth-worker → Redis Blacklist | Fallback Outbox |

| 🔄 Cache Broadcast | RabbitMQ Fanout → ext-authz Blacklist + character-match Catalog (all replicas) Local Cache Sync | AMQP Fanout |

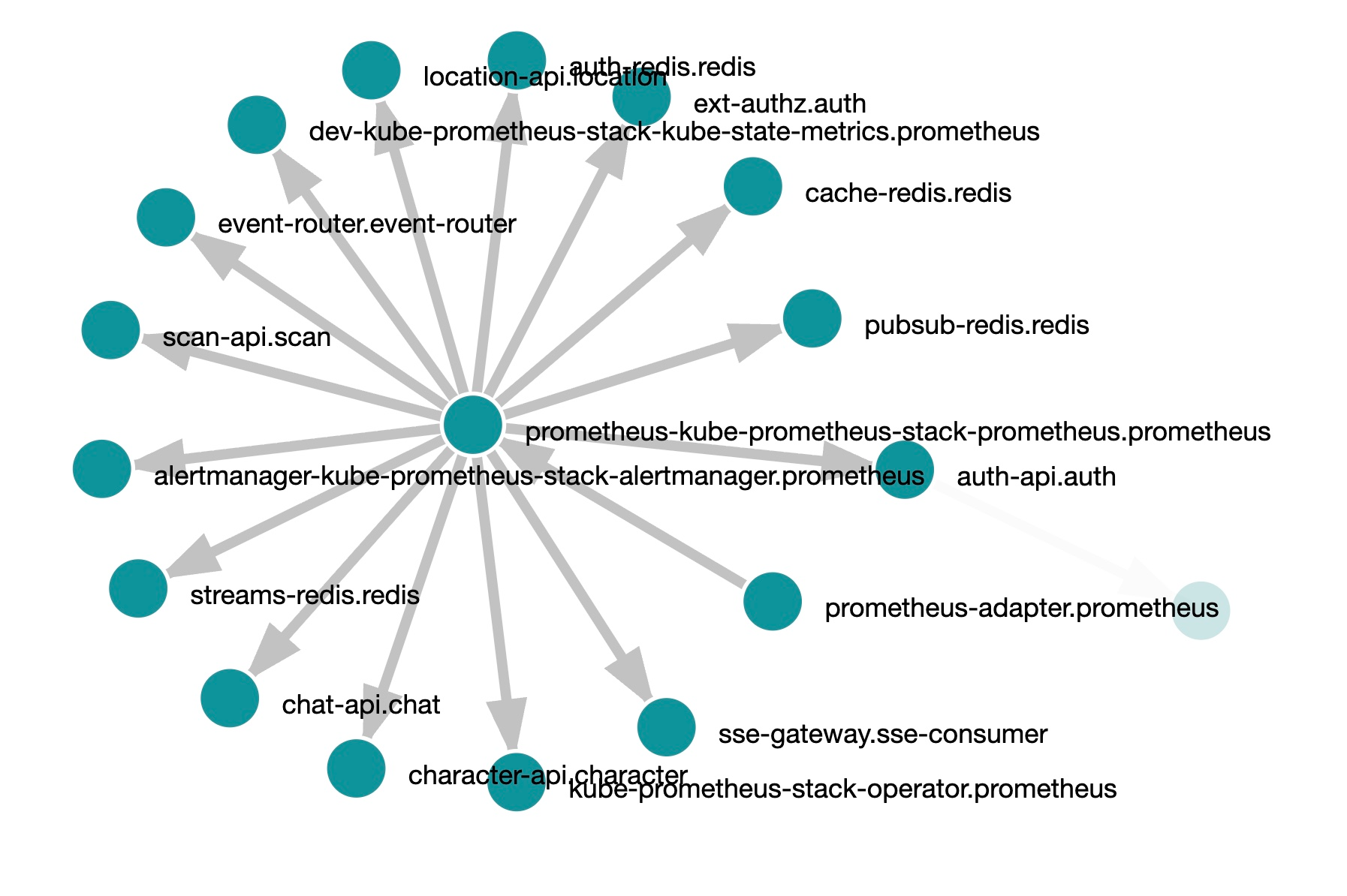

| 📊 Metrics | Envoy Sidecars → Prometheus → Grafana / KEDA Autoscaling | Prometheus scrape |

| 📝 Logs | All Pods (stdout) → Fluent Bit DaemonSet → Elasticsearch → Kibana | HTTP (ECS format) |

| 🔍 Traces | Envoy → OTel Collector → Jaeger (trace_id correlation, Kiali viz) | OTLP, Zipkin |